DeepSeek 是目前最火的应用,日常写作、翻译、问答都能轻松搞定,独特的深度思考模式加上联网搜索,在编程、解题、文献解读等复杂任务中也游刃有余,推理思考能力一绝。短短几天内,DeepSeek 便登顶中美两区苹果应用市场免费榜榜单。

DeepSeek 官网因为某些众所周知的原因,经常宕机不可用,我们可以自己在本地部署 DeepSeek R1 来解决这个问题,无需依赖云端服务。

部署教程

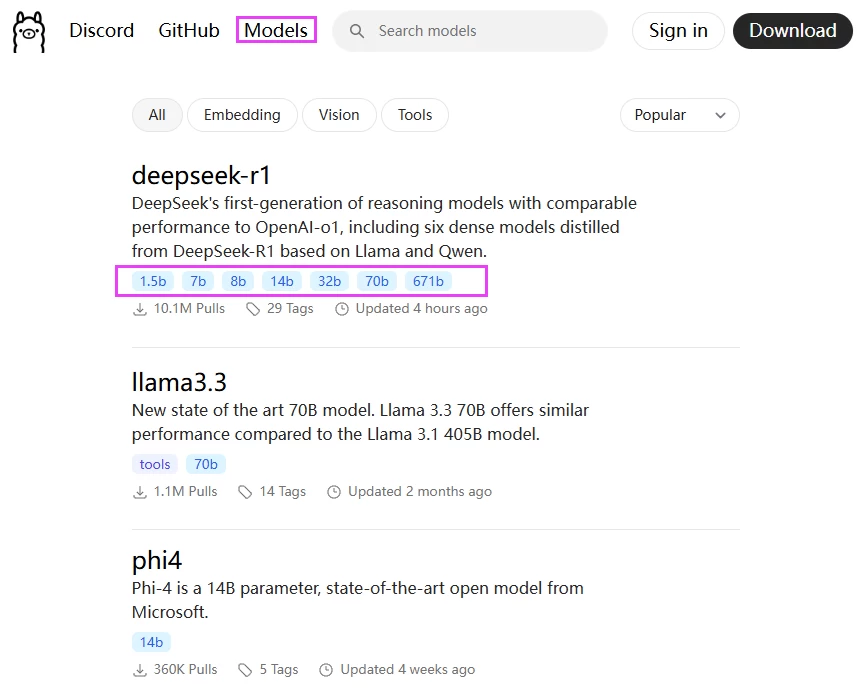

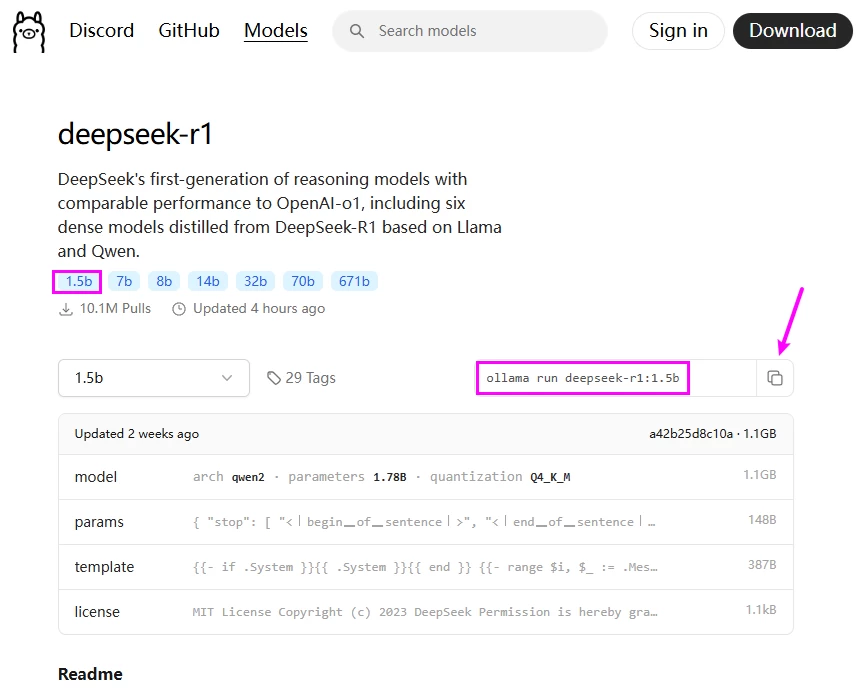

为了方便操作,可以先安装一个 Ollama 软件,它是一个开源的基于Go语言的本地大语言模型运行框架,专门为本地电脑上部署和运行大模型而生的,类似于Docker,支持上传和管理大语言模型仓库,包括 DeepSeek 等模型。在 Ollama 的官网,我们可以下载 Ollama 程序,然后更方便地下载、安装和运行DeepSeek模型。

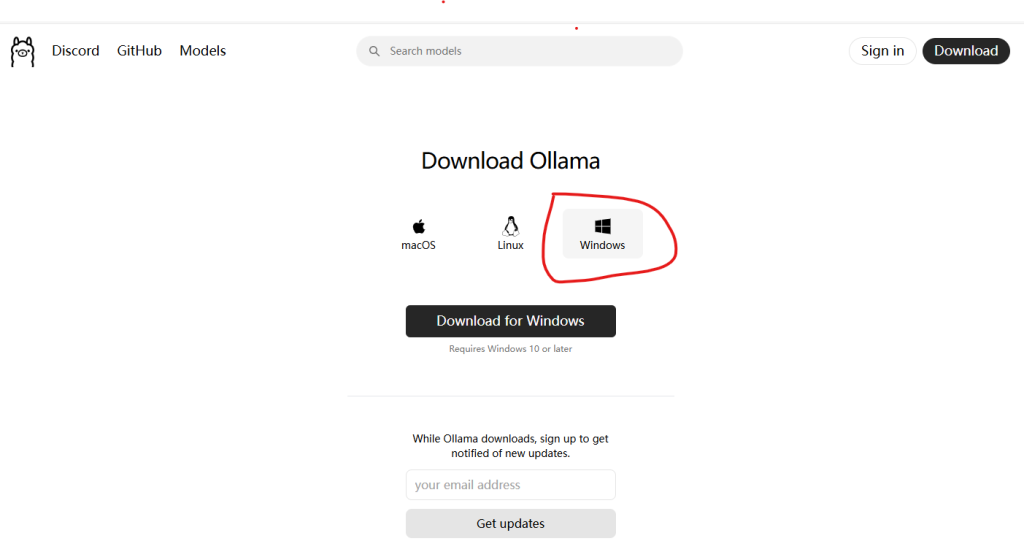

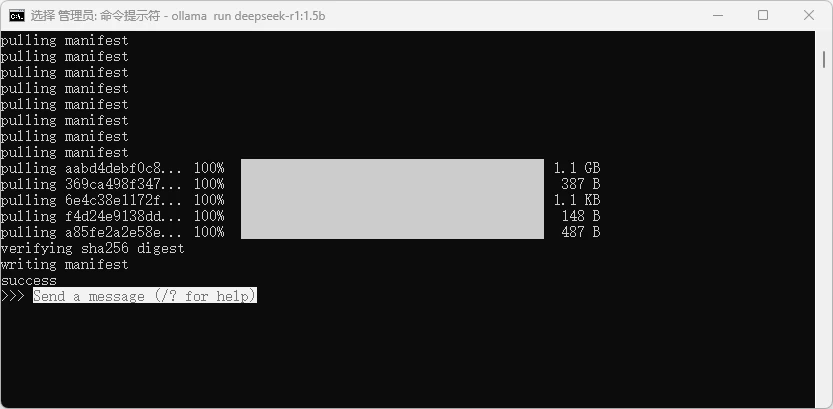

1、打开 Ollama 官网下载地址:https://ollama.com/download,先下载 Ollama 程序,如下图:

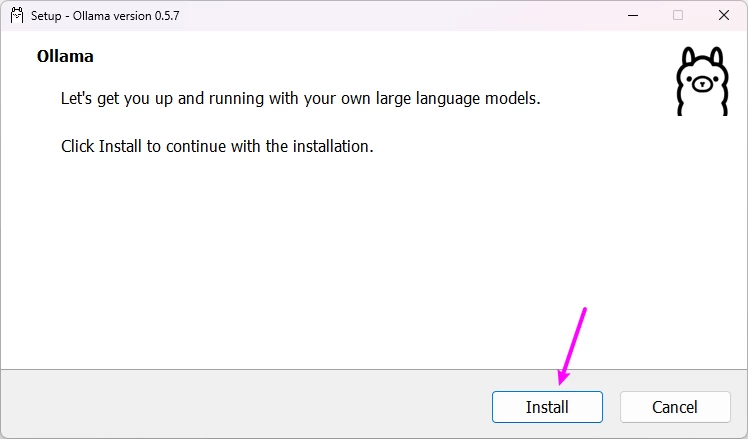

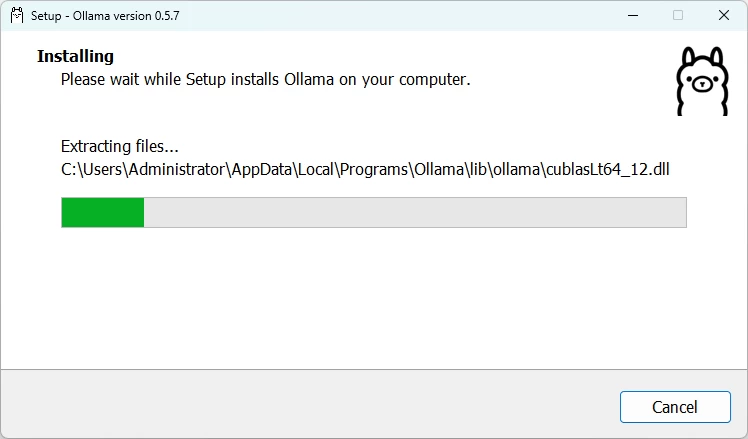

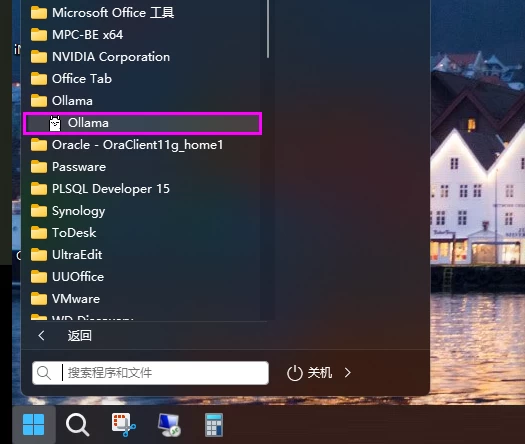

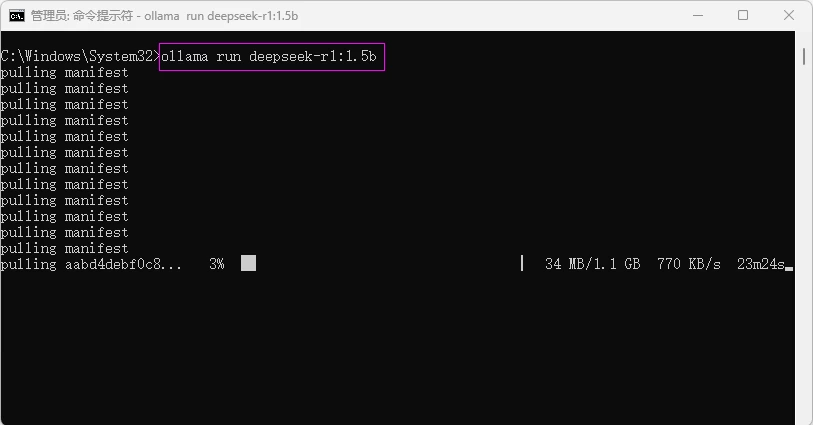

2、以管理员身份安装 Ollama 程序,安装成功后打开 Ollama 程序,如下图:

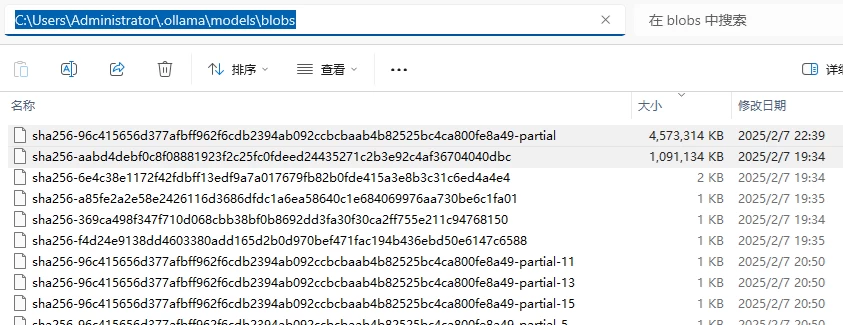

PS:卸载则把命令中的 run 改成 rm 即可,如果想了解更多命令,可以直接输入 ollama 查看。另外,默认情况下,Ollama模型的存储目录如下:

●Windows系统:C:\Users\<用户名>\.ollama\models

●macOS系统:~/.ollama/models

●Linux系统:/usr/share/ollama/.ollama/models

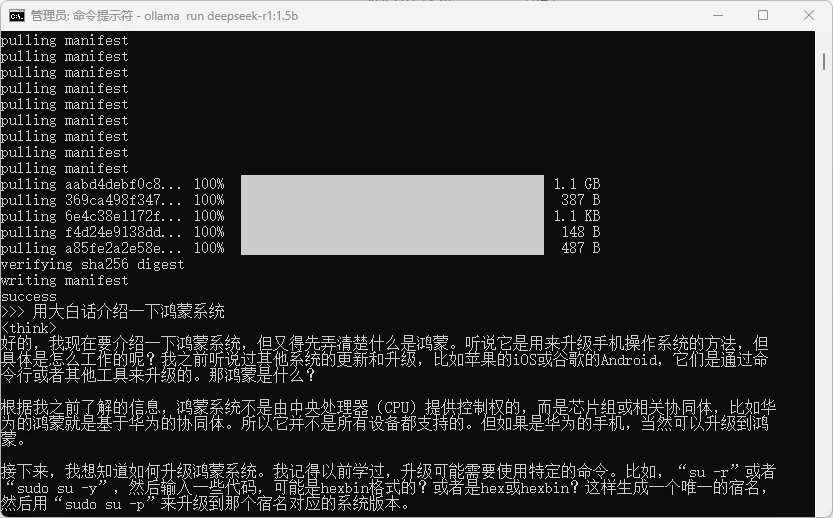

5、部署完成后,我们可以直接在命令窗口输入想问的问题,如下图。

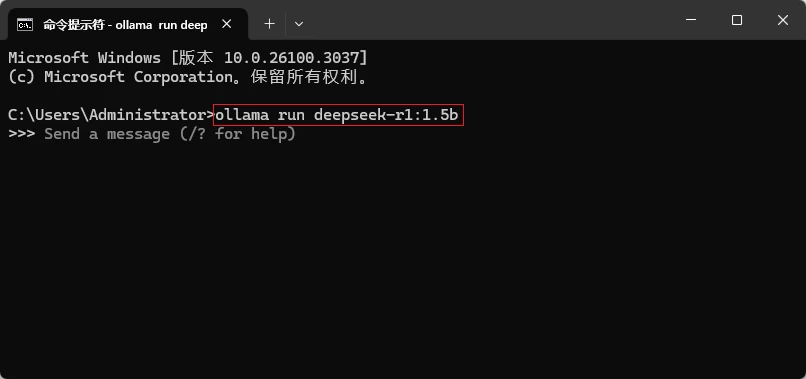

PS:如果想退出对话,直接输入 /bye 即可。当电脑重启后,需要先运行 Ollama 软件,然后打开CMD命令提示符,输入下面的命令即可通过窗口进行对话。

ollama run <a target="_blank" href="https://www.pengqi.club/tag/deepseek" title="View all posts in deepseek">deepseek</a>-r1:1.5b

7、运行本地模型对你的电脑配置有一定要求,包括内存、GPU 等。但运行稳定,不受网速影响。如果出现卡顿,请尝试降低模型参数。有需要的小伙伴可以体验一下!

THE END

暂无评论内容